Decisiones más inteligentes y mejor salud: la promesa del aprendizaje por refuerzo

El AR es una técnica de aprendizaje automático que hoy en día ayuda a los profesionales sanitarios a tomar decisiones óptimas y secuenciales.

¿Alguna vez te has preguntado cómo una computadora podría aprender a jugar un videojuego? Es un sistema llamado Aprendizaje por Refuerzo (AR) y, aunque parezca increíble, ahora se utiliza para ayudar a los médicos a tomar mejores decisiones. El AR es una técnica de aprendizaje automático que hoy en día ayuda a los profesionales sanitarios a tomar decisiones óptimas y secuenciales. Al aprender de los datos de los pacientes, el AR puede desarrollar planes de tratamiento personalizados, lo que se traduce en mejores resultados y una mejor gestión de los recursos. Piénsalo como un asistente inteligente para médicos. El objetivo de este asistente de AR es ayudar a encontrar el mejor plan de tratamiento posible para un paciente, no solo para hoy, sino a largo plazo.

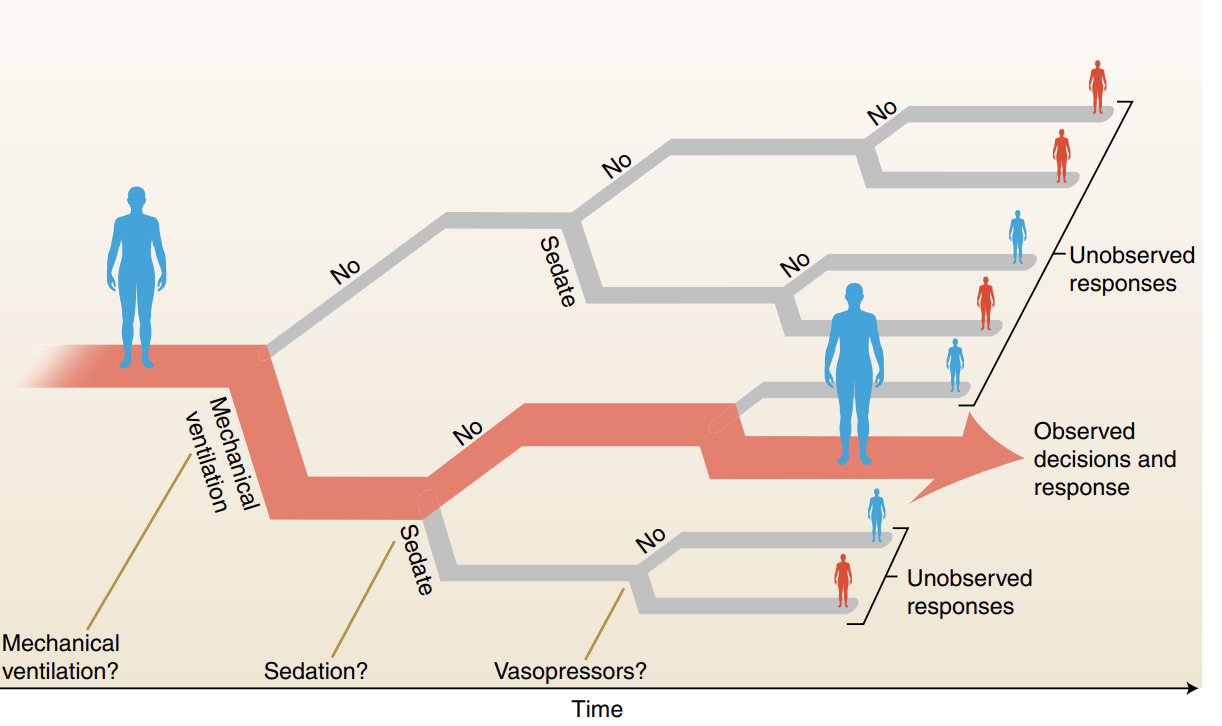

El AR se ha utilizado en diversas aplicaciones médicas. Por ejemplo, se ha aplicado para optimizar la dosificación personalizada de sedantes como el propofol en unidades de cuidados intensivos y la dosificación de insulina para diabéticos tipo 1. Se ha utilizado para identificar regímenes de quimioterapia individualizados para pacientes con cáncer y para mitigar los síntomas de la enfermedad de Parkinson. El AR se ha utilizado en cuidados críticos, como el manejo de la sepsis mediante la optimización de fluidos y vasopresores, y la gestión del respirador para pacientes en estado crítico. Los sistemas basados en RL se están utilizando para mejorar la adaptabilidad y la eficiencia mediante la automatización de tareas quirúrgicas como hacer nudos para mejorar la precisión y ahorrar tiempo.

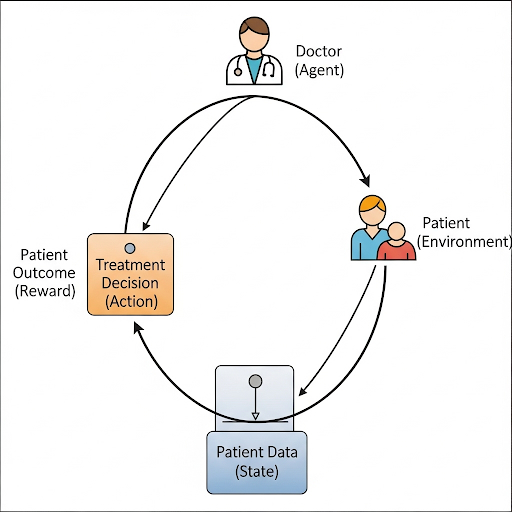

En esencia, el aprendizaje por pares (RL) es un proceso de ensayo y error. Un agente aprende a tomar decisiones interactuando con un entorno. Observa el estado actual, realiza una acción y recibe una recompensa o penalización como retroalimentación. El objetivo es que el agente desarrolle una política (una estrategia para elegir acciones) que maximice sus recompensas acumuladas a lo largo del tiempo.

Agente: La entidad que toma las decisiones (p. ej., un sistema de IA).

Entorno: El sistema externo con el que interactúa el agente (p. ej., el estado de salud de un paciente).

Estado: La situación o condición actual (p. ej., los signos vitales y los resultados de laboratorio de un paciente).Acción: La decisión que toma el agente (p. ej., ajustar la dosis de un medicamento).

Recompensa: Retroalimentación que evalúa la eficacia de la acción (p. ej., una recompensa positiva por un buen resultado, una recompensa negativa por un evento adverso).

Política: La estrategia que el agente aprende a seguir.

Por ejemplo, imaginemos a un médico que trata a un paciente con una enfermedad compleja. No tiene todas las respuestas a la vez y debe tomar una serie de decisiones a lo largo del tiempo para encontrar el mejor tratamiento. Este proceso refleja el funcionamiento de un algoritmo de aprendizaje automático (RL).

El agente es el programa informático que toma las decisiones, al igual que un médico; el algoritmo decide el plan de tratamiento. El entorno es el cuerpo del paciente y todos sus sistemas complejos. El agente de aprendizaje automático interactúa con el entorno. El estado es la información de salud del paciente en un momento dado, que incluye sus resultados de laboratorio, presión arterial, síntomas e historial médico. El agente de aprendizaje automático observa el estado para tomar su siguiente decisión. La acción es la decisión del médico, como recetar un nuevo medicamento, ajustar una dosis o recomendar un cambio en el estilo de vida. El agente de aprendizaje automático realiza estas acciones. La recompensa es el resultado de la decisión del médico. Una recompensa positiva es un buen resultado, como la mejora de la condición del paciente o la desaparición de sus síntomas. Una recompensa negativa (o penalización) es un mal resultado, como un efecto secundario grave o el empeoramiento de la salud del paciente. El agente de RL aprende a elegir acciones que maximizan las recompensas positivas y minimizan las negativas. Con el tiempo, al probar diferentes acciones y recibir retroalimentación (recompensas), el agente de RL aprende la mejor política de tratamiento para mejorar la salud del paciente.

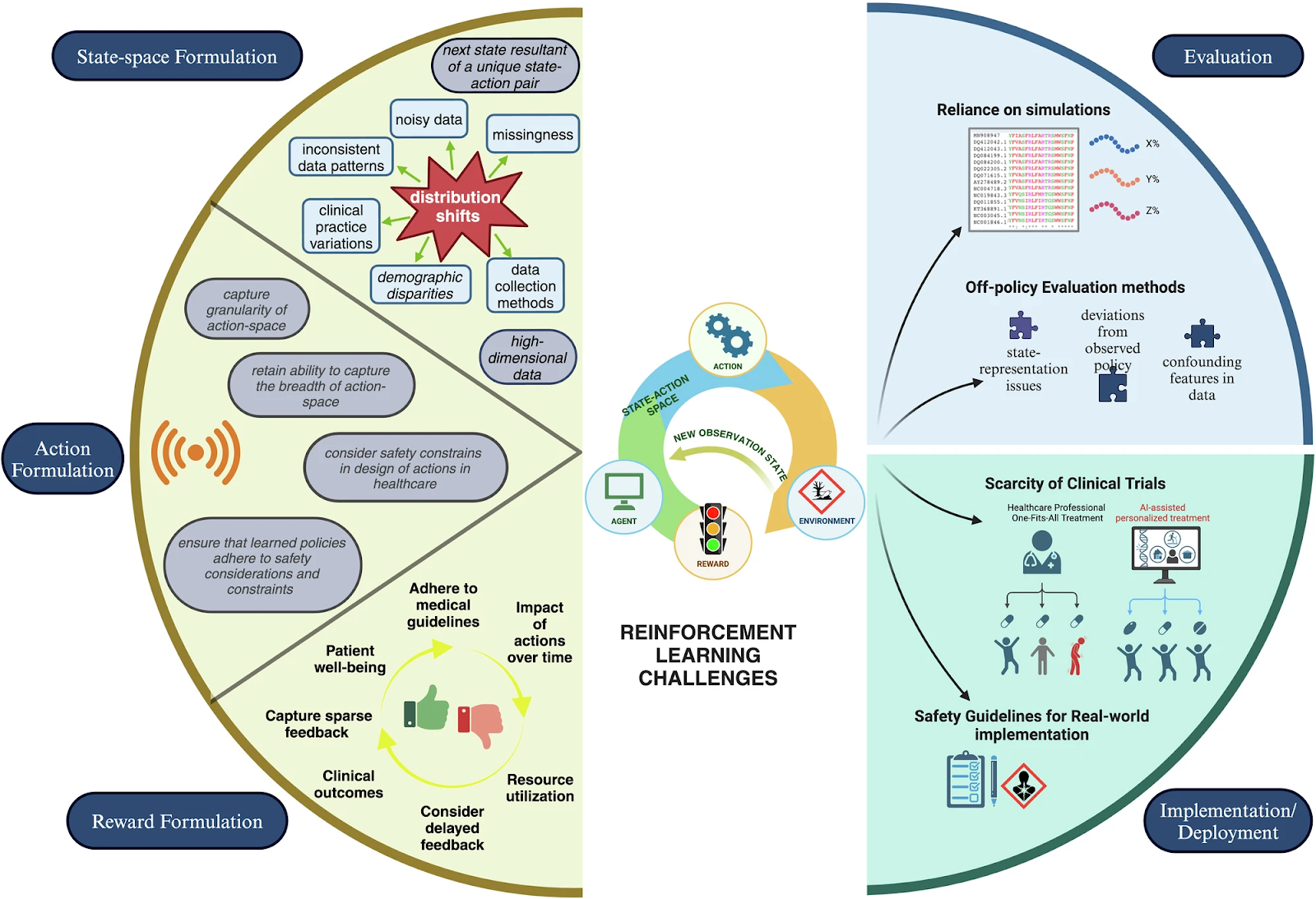

Gracias a su capacidad de aprender de una serie de decisiones, RL es ideal para situaciones donde las decisiones de un médico tienen un efecto dominó a lo largo del tiempo. Para pacientes con enfermedades crónicas como la diabetes, RL puede crear un plan de acción para su atención. Determina el mejor momento para ajustar la medicación o sugerir una revisión para mantenerlos sanos durante muchos años. En cuidados críticos, RL puede ayudar a determinar la dosis ideal de un medicamento, como un sedante o insulina, mediante el análisis constante de las constantes vitales del paciente en tiempo real. Esto ayuda a garantizar que el paciente reciba exactamente lo que necesita, cuando lo necesita. Más allá de la atención al paciente, RL puede ayudar a que los hospitales funcionen mejor. Puede determinar la mejor manera de programar cirugías, gestionar el número de camas en la UCI y predecir cuándo habrá más afluencia en la sala de urgencias, para que el hospital esté siempre listo. A pesar de su potencial, la integración del aprendizaje automático (RA) en la atención médica presenta varios desafíos. Los datos de salud, como las historias clínicas electrónicas, pueden ser de alta dimensión y contener problemas como valores faltantes e inconsistencias, lo que complica la definición del espacio de estados. Diseñar funciones de recompensa es un desafío, ya que implica juicios subjetivos y compensaciones complejas, considerando factores como los resultados clínicos, el bienestar del paciente y la utilización de recursos. Las acciones de atención médica pueden abarcar desde decisiones discretas hasta ajustes continuos, y es difícil equilibrar la granularidad de esta representación de acciones con las restricciones de seguridad y las directrices clínicas. La evaluación de algoritmos de RA es compleja debido a preocupaciones de seguridad, ética y costos, lo que lleva a una dependencia de entornos simulados. La implementación en el mundo real es esencial para una evaluación integral, pero los ensayos clínicos para modelos de RA son escasos.