Facultad de Computación

Sistemas de Información Ciencia de Datos Ciencia de la Computación CiberseguridadFacultad de Negocios

Administración y Negocios Digitales Administración y Negocios Sostenibles Business Analytics

Sabemos que el agua es esencial para la vida y que conforme pasa el tiempo mayor es la preocupación por la disponibilidad y uso de este recurso. Es por ello que nos encontramos en la constante búsqueda de métodos sostenibles y pasivos que nos permitan encontrar soluciones a los problemas del suministro de agua. Para hacer frente a este desafío, el enfoque de la investigación en las últimas décadas ha sido la captación de agua atmosférica; así como la reducción del uso de agua dulce y el tratamiento del agua contaminada.

Se ha demostrado que la recolección de niebla es una fuente viable de agua de buena calidad en muchas partes áridas del mundo, una malla de un metro cuadrado puede recolectar de 9 a 70 litros por día en lugares urbanos (por ejemplo, en Lima, Perú y en Dhofar, Omán) e instalaciones a gran escala (es decir, malla de 5.000 m2) puede recolectar hasta 100.000 litros de agua en un solo día. [1]

No es novedad que, en ciertas regiones de nuestro país, además de otros países usen mallas para recolectar el agua de la atmosfera y así poder combatir la escasez de este recurso. Pero, ¿Qué pasa en las zonas urbanas, dónde a parte de la escasez se tiene que lidiar con la contaminación del aire? Investigadores científicos de la ETH de Zúrich han desarrollado una forma sencilla de recolectar agua de la niebla y eliminar de manera simultanea contaminantes presentes en ella.

Ellos presentan un dispositivo combinado de recolección de niebla y purificación de agua que opera de manera completamente pasiva en exteriores requiriendo luz solar solo para activarse. El revestimiento permanece reactivo incluso cuando no se irradia durante varias horas, lo que permite la recolección y el tratamiento simultáneos de la niebla contaminada, incluso cuando la irradiancia solar es baja, como sería en condiciones de niebla

Para ello se utiliza una malla de alambre metálico recubierta de una mezcla de polímeros especialmente seleccionados y nanopartículas de dióxido de titanio anatasa (fase cristalina de estructura octaédrica). Los polímeros garantizan que las gotas de agua se recolecten de manera eficiente en la malla y desciendan lo más rápidamente posible a un recipiente antes de que sean arrastradas por el viento. El dióxido de titanio actúa como catalizador químico, descomponiendo las moléculas de muchos de los contaminantes orgánicos contenidos en las gotas para hacerlos inofensivos. Además, la humectabilidad de la superficie de la malla está diseñada para mejorar la extracción de agua.

Como resultado de la investigación en pruebas al aire libre, el dispositivo puede mantener un buen rendimiento de recolección de niebla, así como una eficiencia de tratamiento de agua de >85 %. En esa misma línea, la producción continua de agua con purificación pasiva demostrada en este estudio proporciona una solución libre de energía para abordar la escasez de agua, avance que podría ayudar a brindar acceso a agua potable a millones de personas en todo el mundo.

Referencias

Ghosh, R. & Ganguly, R. Harvesting Water from Natural and Industrial Fogs—Opportunities and Challenges in Droplet and Spray Transport: Paradigms and Applications (eds Basu, S. et al.) 237–266 (Springer, 2018).

Schemenauer, R. S., Cereceda, P. & Osses, P. Fog Water Collection Manual (FogQuest, 2022)

El pasado mes salió una noticia acerca del potencial carcinogénico que podría estar aparejado al consumo de aspartamo, un endulzante sintético. La noticia salió a raíz de comentarios emitidos por una agencia de la Organización Mundial de la Salud (OMS). Para entender un poco más de qué se trata esta noticia y el potencial peligro del consumo de alimentos que contengan este endulzante es importante entender su origen, su rol y las cantidades presentes en los alimentos considerados bajas calorías o dietéticos.

¿Qué son los endulzantes artificiales?

Los endulzantes artificiales son mayormente moléculas orgánicas con la capacidad de producir la sensación de dulzor en el paladar y por ende, endulzar aquellos alimentos a los que no se les agrega o se le han removido los azúcares. Este tipo de moléculas tienen un poder endulzante superior al del azúcar de mesa, o sacarosa y es por ello que debido a su bajo aporte calórico se han vuelto parte de múltiples alimentos para aquellas personas que quieran perder peso o padecen algún tipo de enfermedad metabólica, entre ellas, la diabetes. El aspartamo se encuentra entre estas moléculas.

El aspartamo es un aditivo alimentario sintético, bajo en calorías y aproximadamente 200 veces más dulce que el azúcar. Fue descubierto en 1965 por el químico James Schlatter y recién salió al mercado en 1981. Está formado por 2 aminoácidos: el aspartato y un metil éster de fenilalanina (aminoácido modificado). Este endulzante es usado en bebidas, postres, golosinas, productos lácteos, productos reducidos en calorías y como endulzante de mesa (en reemplazo del azúcar), entre otros.

Hasta aquí parecería que no hubiera ningún inconveniente con el aspartamo ya que ha sido parte de nuestras vidas por una buena cantidad de tiempo. Sin embargo, a mediados de julio de este año, la OMS realizó un anunció que avivó la preocupación por la presencia de estos compuestos sintéticos en nuestra alimentación.

La declaración de la agencia dependiente de la OMS mencionaba la inclusión del aspartamo como un producto posiblemente carcinogénico y esto despertó la preocupación por su uso actual y los efectos que podrían venir aparejados con su consumo, especialmente la posible conexión con el cáncer hepático. Sin embargo, es importante revisar la información y el sustento científico para realizar el anuncio. La agencia internacional para la investigación del cáncer (IARC, por sus siglas en inglés) indicó que los estudios en humanos tenían evidencia limitada que solo se basaban en 3 estudios observacionales, ésta en conjunto con el comité de expertos en aditivos alimentarios que es parte de la OMS y de la Organización para la Alimentación y Agricultura (FAO, en inglés) o JECFA, han emitido el comunicado indicando la nueva clasificación. Esta decisión indicaba además que no era necesario el cambio de la ingesta diaria permitida de este endulzante (40 mg/kg de peso, según fuentes norteamericanas y europeas).

Entonces: ¿qué significa esta evidencia? Por un lado, se sabe que los estudios mencionados fueron realizados en animales, por lo que no siempre existe una correlación directa con los humanos. Pueden dar pistas y por ello, requieren de mayor investigación y de ser posible, estudios en humanos. Adicionalmente, un estudio publicado por investigadores de Harvard, la Universidad de Boston y el Instituto Nacional de Cáncer de Estados Unidos, examinó el consumo de bebidas endulzadas en personas con cáncer. Los investigadores encontraron un elevado riesgo de cáncer de hígado en personas con diabetes con un consumo de bebidas gaseosas endulzadas artificialmente. Sin embargo, la revisión no halló un incremento en cáncer hepático en aquellas personas que consumían gaseosas y no presentaban diabetes. Esto quiere decir que los estudios observacionales muestran correlaciones, pero no causas y efectos. Para que el efecto negativo del aspartamo sea evidente, y de acuerdo a los límites permitidos de su ingesta, deberíamos sobrepasar un equivalente al consumo de 9 a 14 latas de gaseosas diarias o aproximadamente 4 litros al día.

El mensaje final es seguir siendo cuidadosos en la selección de los alimentos y bebidas que consumimos, buscar ingredientes saludables y no confundirlos con seguros. Recordar que el consumo excesivo de azúcares refinados pueden llevar a la aparición de obesidad y otras enfermedades metabólicas. Más allá de que los endulzantes artificiales puedan servir para reducir el consumo de azúcar, no ofrecen ningún beneficio para la salud y lo ideal sería dejar de consumirlos.

Referencias:

https://www.efsa.europa.eu/en García, B. “El aspartamo sigue siendo seguro (y la OMS debería revisar cómo lanza sus mensajes)”. El Mundo [España], 14/07/2023.

Jewett, C. “Aspartame is a possible cause of Cancer in Humans, a WHO Agency says”. The New York Times [Estados Unidos], 13/07/2023.

Magnuson, B. et al. (2016) Biological fate of low-calorie sweeteners, Nutrition Reviews Vol. 74(11):670–689. doi: 10.1093/nutrit/nuw032

Timberlake, K. (2019) Chemistry An Introduction to General, Organic, and Biological Chemistry, 13th Edition, Pearson.

El pasado mes salió una noticia acerca del potencial carcinogénico que podría estar aparejado al consumo de aspartamo, un endulzante sintético. La noticia salió a raíz de comentarios emitidos por una agencia de la Organización Mundial de la Salud (OMS). Para entender un poco más de qué se trata esta noticia y el potencial peligro del consumo de alimentos que contengan este endulzante es importante entender su origen, su rol y las cantidades presentes en los alimentos considerados bajas calorías o dietéticos.

¿Qué son los endulzantes artificiales?

Los endulzantes artificiales son mayormente moléculas orgánicas con la capacidad de producir la sensación de dulzor en el paladar y por ende, endulzar aquellos alimentos a los que no se les agrega o se le han removido los azúcares. Este tipo de moléculas tienen un poder endulzante superior al del azúcar de mesa, o sacarosa y es por ello que debido a su bajo aporte calórico se han vuelto parte de múltiples alimentos para aquellas personas que quieran perder peso o padecen algún tipo de enfermedad metabólica, entre ellas, la diabetes. El aspartamo se encuentra entre estas moléculas.

El aspartamo es un aditivo alimentario sintético, bajo en calorías y aproximadamente 200 veces más dulce que el azúcar. Fue descubierto en 1965 por el químico James Schlatter y recién salió al mercado en 1981. Está formado por 2 aminoácidos: el aspartato y un metil éster de fenilalanina (aminoácido modificado). Este endulzante es usado en bebidas, postres, golosinas, productos lácteos, productos reducidos en calorías y como endulzante de mesa (en reemplazo del azúcar), entre otros.

Hasta aquí parecería que no hubiera ningún inconveniente con el aspartamo ya que ha sido parte de nuestras vidas por una buena cantidad de tiempo. Sin embargo, a mediados de julio de este año, la OMS realizó un anunció que avivó la preocupación por la presencia de estos compuestos sintéticos en nuestra alimentación.

La declaración de la agencia dependiente de la OMS mencionaba la inclusión del aspartamo como un producto posiblemente carcinogénico y esto despertó la preocupación por su uso actual y los efectos que podrían venir aparejados con su consumo, especialmente la posible conexión con el cáncer hepático. Sin embargo, es importante revisar la información y el sustento científico para realizar el anuncio. La agencia internacional para la investigación del cáncer (IARC, por sus siglas en inglés) indicó que los estudios en humanos tenían evidencia limitada que solo se basaban en 3 estudios observacionales, ésta en conjunto con el comité de expertos en aditivos alimentarios que es parte de la OMS y de la Organización para la Alimentación y Agricultura (FAO, en inglés) o JECFA, han emitido el comunicado indicando la nueva clasificación. Esta decisión indicaba además que no era necesario el cambio de la ingesta diaria permitida de este endulzante (40 mg/kg de peso, según fuentes norteamericanas y europeas).

Entonces: ¿qué significa esta evidencia? Por un lado, se sabe que los estudios mencionados fueron realizados en animales, por lo que no siempre existe una correlación directa con los humanos. Pueden dar pistas y por ello, requieren de mayor investigación y de ser posible, estudios en humanos. Adicionalmente, un estudio publicado por investigadores de Harvard, la Universidad de Boston y el Instituto Nacional de Cáncer de Estados Unidos, examinó el consumo de bebidas endulzadas en personas con cáncer. Los investigadores encontraron un elevado riesgo de cáncer de hígado en personas con diabetes con un consumo de bebidas gaseosas endulzadas artificialmente. Sin embargo, la revisión no halló un incremento en cáncer hepático en aquellas personas que consumían gaseosas y no presentaban diabetes. Esto quiere decir que los estudios observacionales muestran correlaciones, pero no causas y efectos. Para que el efecto negativo del aspartamo sea evidente, y de acuerdo a los límites permitidos de su ingesta, deberíamos sobrepasar un equivalente al consumo de 9 a 14 latas de gaseosas diarias o aproximadamente 4 litros al día.

El mensaje final es seguir siendo cuidadosos en la selección de los alimentos y bebidas que consumimos, buscar ingredientes saludables y no confundirlos con seguros. Recordar que el consumo excesivo de azúcares refinados pueden llevar a la aparición de obesidad y otras enfermedades metabólicas. Más allá de que los endulzantes artificiales puedan servir para reducir el consumo de azúcar, no ofrecen ningún beneficio para la salud y lo ideal sería dejar de consumirlos.

Artificial intelligence techniques have been around for several decades, and are not just limited to machine learning, neural networks, fuzzy logic or deep learning. There is a technique that allows modelling temporal states of highly complex systems and is able to predict changes in these systems by applying simple evolutionary rules. This artificial intelligence technique is known as the Cellular Automata paradigm.

Cellular Automata (CA) are small elements that occupy spaces or unit cells within a discrete two- or three-dimensional domain called a lattice or grid, which volume represents the modelled system (Figure 1). Each automaton located in a cell of this lattice has a state, within a group of predefined states, which through interaction with itself and with its neighbouring cells can maintain or change through the iterations of evolution of the modelled system, because each automaton has the ability to make decisions independently to maintain or change that state as the system evolves. By projecting this automaton behaviour on a larger scale, it is possible to model highly complex systems whose macro behaviour is governed by the behaviour of its smaller component units.

Figure 1. Configuration of a cellular automaton in its cell in a two-dimensional lattice [1].

The evolution of the automaton's state is based on the application of very simple individual evolution rules. In each iteration, the automaton knows only its own state and the state of its nearest neighbours, and depending on these states and the evolution rules, the automaton evolves to the next iteration either maintaining or changing its state.

The cells containing the automata, which in turn form the lattice or domain of the modelled system, may be square, triangular or polygonal in the two-dimensional case, or hexahedral or tetrahedral in the three-dimensional domain.

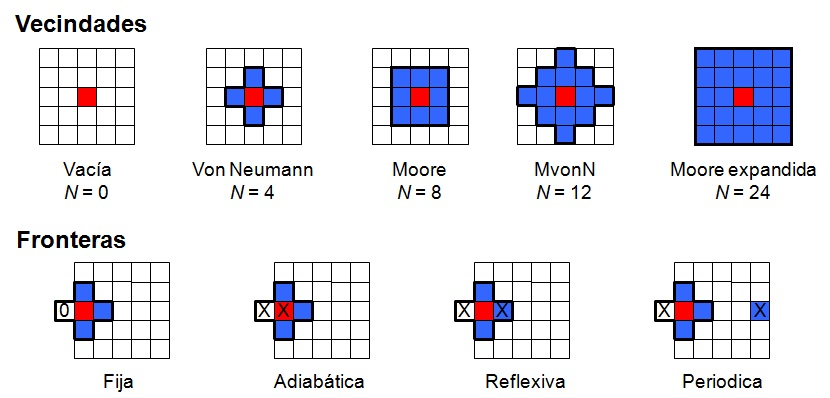

In order to know the state of its neighbours, the automaton uses a type of neighbourhood to relate to its environment, which depends on the number of neighbouring automata taken into account. The used neighbourhoods range from the empty neighbourhood, in which the automaton only takes itself into account, to the neighbourhoods that take into account four (von Neumann), eight (Moore), twelve (expanded von Neumann, MvonN) or twenty-four (expanded Moore) neighbours. The latter includes the neighbouring automata at the first and second level of distance (Figure 2, top).

Figure 2. Neighbourhoods (top) and Boundaries (bottom) considered in the implementation of cellular automata [2].

When the automaton is at a boundary of the domain, it also takes into account different configurations for the hypothetical neighbouring cells located outside the boundary, which assign them specific states for iteration and evolution. Within the configurations for these out-of-domain positions, they can be assigned a null state (fixed boundary), the same state as the automaton on the boundary (adiabatic boundary), the same state as the automaton on the contralateral side of the boundary (reflexive boundary) or the state of the automaton on the same row at the opposite end of the lattice (periodic boundary), (Figure 2, bottom).

The cellular automata paradigm appeared in the 1940s by Stanislaw Ulam to describe graphically the growth of crystals. Simultaneously, Von Neumann used the same tool to study systems capable of self-replication. In the 1970s, John Conway used the concept of CAs to create the game of life, a model of the dynamic ability of automata to move and replicate themselves by implementing simple evolutionary rules (Figure 3, A). In 1983, Wolfram presents in his work a new kind of science the development of several rules that generate series of self-replicating regular and irregular shapes (Figure 3, B). In 1993, Ermentrout et al. used CAs for the first time in the generation of biological networks such as the neural system and the circulatory system, taking the model as a continuous process (Figure 3, C). By 2004, Deutch et al. developed the first models of tumour growth (Figure 3, D).

Figure 3. Historical developments of cellular automata: (A) Conway's game of life, (B) Wolfram's regular and irregular networks, (C) Ermentrout's neural and cardiovascular networks, and (D) Deutch's tumour growth models [1].

To date, cellular automata have been used to simulate and predict behaviour in diverse systems such as fractal formation, the behaviour of bacterial populations, traffic analysis in large cities, the creation of structures by topological optimisation, and even tissue architecture and healing time in a bone fracture repair process (Figure 4).

Figure 4. Two-dimensional axisymmetric model of cellular automata for the simulation of the process of osteogenesis and bone fracture repair. The architecture of the component tissues of the bone callus are represented with different colours (red: bone marrow; yellow: fatty bone marrow; light blue: granular and fibrous tissue; dark blue: cartilage; white: bone). The repair time t is given in days [1].

In summary, cellular automata, a prominent technique in artificial intelligence, allow the behaviour of a variety of highly complex systems to be analysed and predicted in a simple and straightforward manner.

References

[1] A.J. Arias-Moreno. “Modelo computacional para la simulación del proceso de osteogénesis y curación ósea después de la fractura”. Master thesis, Universidad Nacional de Colombia, Colombia, january 2011.

[2] A. Tovar. “Bone remodeling as a hybrid cellular automaton optimization process”. Doctoral thesis, University of Notre Dame, United States, december 2004.

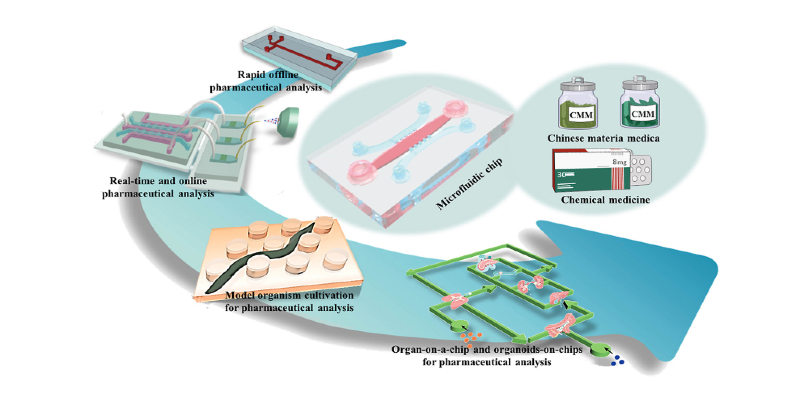

Los dispositivos de microfluidos han marcado el comienzo de una nueva era de innovación, cautivando a la comunidad científica con su notable capacidad para manipular fluidos a escala minúscula. Estos dispositivos representan un gran avance en el campo y ofrecen precisión, eficiencia y versatilidad sin precedentes. Como investigador que busca constantemente herramientas novedosas para avanzar en mi trabajo, estoy profundamente impresionado por el poder transformador de los dispositivos de microfluidos.

Una de las características más destacadas de los dispositivos de microfluidos es su capacidad para manejar pequeñas cantidades de fluidos, a menudo en el rango de microlitros o incluso nanolitros. Esto no sólo conserva valiosos reactivos y muestras, sino que también permite realizar experimentos complejos que antes eran inconcebibles. Ya sea la mezcla precisa de múltiples reactivos, la separación eficiente de biomoléculas o la creación de gradientes complejos, los microfluidos otorgan a los investigadores un control incomparable sobre sus configuraciones experimentales. La adaptabilidad de los dispositivos de microfluidos es realmente sorprendente. Estos dispositivos se pueden adaptar a diversas aplicaciones, desde biología y química hasta ciencia e ingeniería de materiales. Actualmente con bastante facilidad se pueden diseñar plataformas de microfluidos para imitar condiciones fisiológicas, lo que permitía a los investigadores simular de cerca escenarios del mundo real biológico. Esto no sólo mejoran la precisión de los resultados sino que también aceleran el ritmo de los descubrimientos al permitir una experimentación de alto rendimiento.

En la práctica, los dispositivos de microfluidos tienen una clara ventaja a los procesos de laboratorio tradicionales que demandaban una cantidad significativa de tiempo y recursos. Ahora con los dispositivos de microfluidos se pueden ejecutar estos experimentos en una fracción del tiempo. Ademas, la integración de múltiples pasos dentro de un solo dispositivo reduce el riesgo de contaminación, optimiza los flujos de trabajo y garantiza resultados consistentes y confiables. Esta naturaleza compacta es una gran ayuda para los laboratorios ya que maximiza la utilización de áreas limitadas de trabajo. Usar estos dispositivos es sorprendentemente sencillo debido a la gran cantidad de recursos disponibles que comprenden desde software para diseño y simulación hasta manuales completos para fabricación y operación. Ademas hay grupos online donde los investigadores comparten abiertamente sus ideas, fomentando un entorno de apoyo tanto para los recién inician como para los expertos. Los dispositivos de microfluidos han revolucionado el panorama de las pruebas de COVID-19 al permitir ensayos de diagnóstico rápidos y precisos. Estos dispositivos pueden procesar pequeños volúmenes de muestras de pacientes y brindar resultados en minutos. Mediante la integración de varios pasos (preparación de muestras, amplificación y detección) en una sola plataforma, los dispositivos de microfluidos mejoran la eficiencia y reducen el riesgo de contaminación. Esta capacidad ha sido particularmente crucial en entornos de alto riesgo como hospitales, aeropuertos y centros de pruebas comunitarios.

Los dispositivos de microfluidos han sido fundamentales para llevar las pruebas al punto de atención. Estas plataformas portátiles y fáciles de usar permiten a los proveedores de atención médica realizar pruebas al lado de la cama, eliminando la necesidad de enviar muestras a laboratorios centrales y agilizando la atención al paciente. Su adaptabilidad y facilidad de uso han sido fundamentales para ampliar la capacidad de prueba, especialmente en entornos con recursos limitados. Los dispositivos de microfluidos también han desempeñado un papel vital en la aceleración del desarrollo y la investigación de vacunas. Permiten la manipulación precisa de células inmunes y antígenos, lo que ayuda en el diseño y optimización de candidatos a vacunas. Además, los microfluidos facilitan el estudio de las respuestas inmunitarias a nivel unicelular, arrojando luz sobre cómo reacciona el cuerpo al virus y a las posibles vacunas.

Los dispositivos de microfluidos ofrecen una plataforma invaluable para probar posibles medicamentos y terapias antivirales. Los investigadores pueden crear microambientes que imiten los tejidos humanos, permitiendo el estudio de las interacciones farmacológicas y sus efectos sobre el virus. Estos dispositivos también ayudan a comprender el comportamiento del virus y a identificar posibles objetivos farmacológicos. Los dispositivos de microfluidos no están exentos de desafíos como cualquier tecnología. Las complejidades de fabricación y la posibilidad de que se produzcan obstrucciones o fugas pueden plantear dificultades, pero con la práctica y la cantidad de recursos disponibles esto se puede superar. Además, si bien los costos iniciales de equipos y materiales pueden ser altos, los ahorros a largo plazo en reactivos y mano de obra justifican la inversión.

En esta era sin precedentes, los dispositivos de microfluidos han demostrado ser herramientas innovadoras y versátiles. Su impacto se extiende mucho más allá de la COVID-19 y promete avances en el diagnóstico, la atención sanitaria y la investigación en diversas disciplinas. En conclusión, los dispositivos de microfluidos son una herramienta revolucionaria. Su capacidad para miniaturizar y controlar con precisión los procesos fluídicos abre la puerta a un mundo de posibilidades, desde avanzar en el diagnóstico médico hasta desentrañar las complejidades del comportamiento celular. Los avances que permiten no son meramente incrementales; son transformadores e impresionantes.

Fig. 1. Las plataformas de microfluidos son dispositivos de miniaturización con alta precisión y exactitud que tienen la capacidad de alto rendimiento, alta eficiencia analítica y automatización.

Actualmente profesores de Bioingeniería de UTEC se encuentran trabajando en proyectos relacionados a los dispositivos de microfluídica con aplicaciones biológicas. Si estás interesado en ser parte de los proyectos que esperas: ¡Únete a Bioingeniería de la UTEC!

Por: Paul Cárdenas Lizana

References

J.S. Kim et al. Microfluidics in healthcare: recent advancements and future prospects Biosens. Bioelectron. (2017)

L. Zhang et al. Microfluidics in pharmaceuticals: recent developments, challenges, and future prospects J. Control. Release (2020)

Y. Li et al. Microfluidics in drug discovery and development Expert Opin. Drug Discov. (2018)

J.S. Kim et al. Microfluidics-based platforms for personalized medicine Biosens. Bioelectron. (2018)

J. Li et al. Microfluidic technologies for the manufacturing of pharmaceuticals Expert Opin. Drug Deliv. (2019)

Lijuan Ma et al., Advances in application and innovation of microfluidic platforms for pharmaceutical analysis, TrAC Trends in Analytical Chemistry, Volume 160, 2023, 116951, ISSN 0165-9936

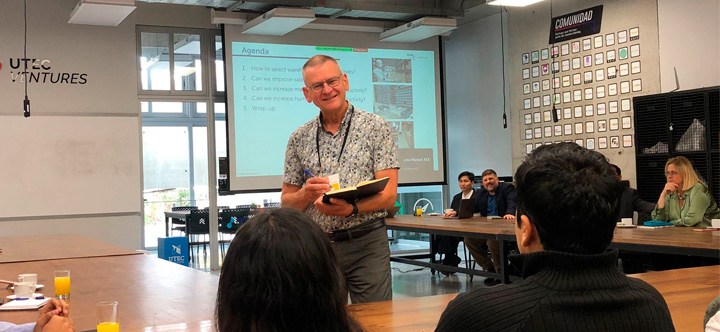

La tendencia en los almacenes a nivel mundial va indudablemente hacia la robotización y automatización. Esto ya se aprecia con mayor claridad en sectores como retail y alimentos. Por ejemplo, en el continente europeo existen, al menos, 40 almacenes completamente automatizados con un número reducido de personas u operadores. Este panorama fue analizado por René de Koster, experto global en logística y gestión de operaciones de Países Bajos, en dos eventos realizados en el campus de la universidad. El primero una charla magistral frente a estudiantes de Ingeniería Industrial y otras carreras y el segundo, un conversatorio con empresas líderes del sector logístico y retail del país.

De Koster, invitado especial de la carrera de Ingeniería Industrial, se ha posicionado como un referente mundial en la investigación sobre diseño y operación de centros de distribución y terminales portuarios con más de 230 publicaciones habiendo sido director del Departamento de Tecnología y Gestión de Operaciones de la Rotterdam School of Management (RSM), Universidad de Erasmus, en los Países Bajos.

De acuerdo con él, la tendencia a la automatización y robotización en el sector debe ir también de la mano con la búsqueda del bienestar de los trabajadores, ya que al tener personas comprometidas con la empresa, el rendimiento será mejor para aprovechar la flexibilidad que ofrecen las personas. Es por ello que vale la pena invertir en la satisfacción laboral, además de la robotización en los almacenes.

Los resultados de sus investigaciones demuestran que a través de retroalimentación, el uso de metas e incentivos se pueden aumentar la productividad, pero mejorar la calidad y seguridad es más desafiante. Al respecto, sus investigaciones encontraron que el liderazgo transformacional impacta en tener menor incidencia de accidentes.

"Se tienen que mejorar las tecnologías que se puedan usar, pero todavía se necesitará de operadores. Si no tienes personas comprometidas detrás o si los operadores no están acostumbrados a trabajar con estas máquinas, se van a ir a trabajar para otra empresa, por lo que tendrás que capacitar a alguien más, lo que requiere mucho más esfuerzo. Es mejor retener a tus propios trabajadores competentes. Si se hace la implementación adecuada con la automatización y los robots, será especialmente para quitar la parte monótona y repetitiva del trabajo. La parte interesante quedará para las personas, ya que suele ser difícil de automatizar”, recalcó el especialista, quien fue invitado especial de la carrera de Ingeniería Industrial para este evento.

En el Perú existen experiencias relevantes en automatización de almacenes y operaciones logísticas. Uno de los que se dio a conocer a través de medios es el de Falabella, que, a inicios de este año, inauguró su primer almacén robotizado de pedidos online. Del mismo modo, Ferreyros, representante de Caterpillar en Perú, dio a conocer que viene implementando el uso de robots para agilizar el 50% de los repuestos en su centro de distribución, permitiéndoles reducir los tiempos de atención a los clientes y lograr un despacho más eficiente a las sucursales.

“Desde la visión de De Koster, no solo hay que actualizarse y conocer las últimas tendencias de almacenaje, sino también desarrollar una visión a futuro de lo que pueden hacer las empresas peruanas identificando los retos de hoy y del mañana y además destacar el papel del empleado como un engranaje clave dentro de todo que potencia la flexibilidad”, destacó José Larco, director de la carrera de Ingeniería Industrial de UTEC.

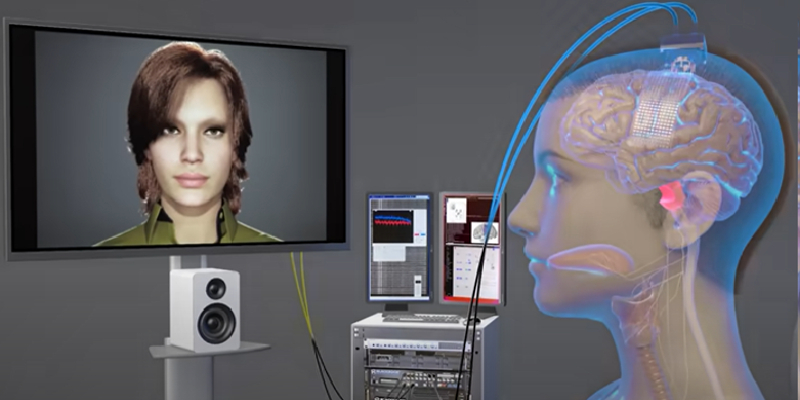

Hace dieciocho años, Ann que entonces tenía 30 años, sufrió un derrame en el tronco encefálico que la dejó gravemente paralizada, perdiendo el control de todos los músculos de su cuerpo. Al principio ni siquiera podía respirar por sí misma. Hasta el día de hoy, los médicos aún desconocen las causas del derrame.

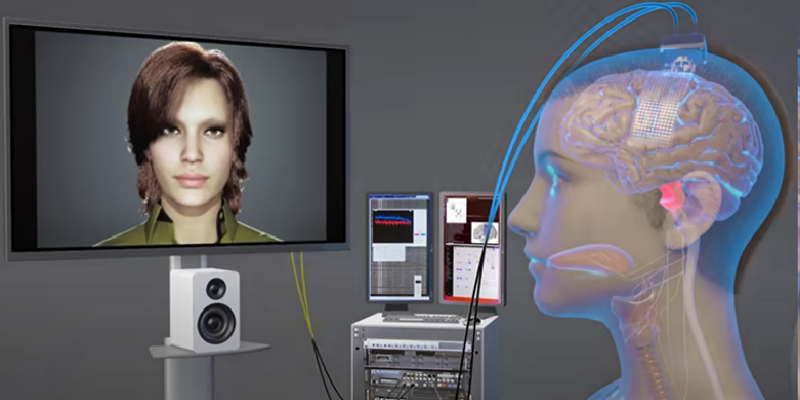

Un grupo de investigadores de la Universidad de California liderado por el Dr. Edward F. Chang ha desarrollado una interfaz cerebro-computadora que decodifica las señales cerebrales de la paciente (Ann) y las convierte en voz sintetizada que un avatar digital pronuncia en voz alta. Este avatar, al mismo tiempo, reproduce movimientos faciales, haciendo que la mandíbula se abra y se cierra y los labios se muevan. También es capaz de recrear los movimientos faciales de alegría, tristeza y sorpresa. El sistema puede convertir estas señales en texto a una velocidad de 78 palabras por minuto, con una tasa media de error de palabras del 25%, superando sistemas similares. En lugar de reconocer palabras completas, el sistema identifica fonemas, unidades mínimas sonoras del habla, mejorando la velocidad y la precisión. El sistema solo necesitó aprender 39 fonemas para descifrar cualquier palabra en inglés. A fin de capturar las señales, los investigadores implantaron 253 electrodos de matriz sobre la superficie del surco lateral (cisura de Rolando) del cerebro de la paciente. Estos electrodos se conectaron a través de un cable a un puerto fijado a su cabeza, que es utilizado para enviar las señales eléctricas cerebrales a las computadoras. Para crear la voz digital del avatar, el equipo ideó un algoritmo de inteligencia artificial para reconocer señales cerebrales únicas para el habla. Luego, se usó la voz de la paciente antes de la lesión, extraída de una grabación de ella hablando en su boda.

Este trabajo de investigación desarrollado por los departamentos de Bioingeniería de la Universidad de California en Berkeley y en San Francisco, ofrece la posibilidad a usuarios que no pueden hablar de comunicarse casi a la misma velocidad que las personas sanas y de tener conversaciones mucho más fluidas. Este es un ejemplo notable de cómo la Bioingeniería puede ayudar a mejorar la calidad de vida de personas que padecen daños corporales permanentes.

Por: Harry Saavedra

Referencias

Metzger, S.L., Littlejohn, K.T., Silva, A.B. et al. A high-performance neuroprosthesis for speech decoding and avatar control. Nature (2023). https://doi.org/10.1038/s41586-023-06443-4 GitHub - UCSF-Chang-Lab BRAVO/multimodal-decoding: Code associated with the paper titled "A high- performance neuroprosthesis for speech decoding and avatar control" , published in Nature in 2023.

https://www.youtube.com/watch?v=iTZ2N-HJbwA

Eighteen years ago, Ann, then 30, suffered a brain stem stroke that left her severely paralyzed, losing control of every muscle in her body. At first she couldn't even breathe on her own. To this day, doctors still do not know the causes of stroke.

A group of researchers at the University of California led by Dr. Edward F. Chang has developed a brain-computer interface that decodes the patient's (Ann) brain signals and converts them into synthesized speech that is spoken aloud by a digital avatar. This avatar reproduces facial movements involving the jaw and lips when necessary. The avatar is also able to recreate the facial movements of joy, sadness, and surprise in order to show feelings. The system can convert brain signals to text at a speed of 78 words per minute, with an average word error rate of 25%, surpassing existing technologies. Instead of recognizing full words, the system identifies phonemes, which are the smallest units of speech, improving speed and accuracy. The system only needed to learn 39 phonemes to decipher any English word. In order to capture the signals, researchers implanted 253 array electrodes on the surface of the lateral sulcus (fissure of Rolando) of the patient's brain. These electrodes connect via a wire to a port (attached to the head), which is used to send the brain's electrical signals to computers. To create the avatar's digital voice, the team devised an artificial intelligence algorithm to recognize unique brain signals for speech. Then, researchers used the patient's voice before the injury, using a recording of her wedding speech.

This work developed by the Bioengineering departments of the University of California at Berkeley and San Francisco offers users who cannot speak the possibility of communicating almost at the same speed as healthy people and having much more fluent conversations. This is a remarkable example of how Bioengineering can help improve the quality of life of people who suffer permanent damage.

References

Metzger, S.L., Littlejohn, K.T., Silva, A.B. et al. A high-performance neuroprosthesis for speech decoding and avatar control. Nature (2023). https://doi.org/10.1038/s41586-023-06443-4

GitHub - UCSF-Chang-Lab-BRAVO/multimodal-decoding: Code associated with the paper titled "A high- performance neuroprosthesis for speech decoding and avatar control" , published in Nature in 2023.

https://www.youtube.com/watch?v=iTZ2N-HJbwA

Los bacteriófagos tienen un gran potencial como sistema de expresión de componentes. Desde hace décadas se emplea a los fagos para el desarrollo de nuevos antimicrobianos, anticuerpos monoclonales y recientemente el desarrollo de nuevos biomateriales. El bacteriófago mas empleado para dicho fin es el fago filamentoso M13; cuya estructura permite combinar las proteínas de su superficie con proteínas de interés presentadas. El virus M13 tiene la capacidad de infectar a cepas de Escherichia coli cepas que muestran el F-pilus [1]. Posee ADN de cadena sencilla con una cápside compuesta por la proteína PVIII y cuatro proteínas de cubierta menores (PIII, PVI, PVII y PIX). Posee 2700 copias de la proteína PVIII que conforman el cilindro principal, y cinco copias de la proteínas PIII y PVI y PVII y PIX en sus extremos. Las proteínas PVIII y PIII son las más comúnmente empleadas para realizar el procedimiento conocido como despliegue de bacteriófagos o “phage display” [1,2].

El desarrollo de anticuerpos depende de una cuidadosa selección de la afinidad antígeno/anticuerpo. Usualmente una biblioteca de variantes de anticuerpos se inserta genéticamente al vector conteniendo el genoma viral en donde se fusiona la proteína gp3 (PIII) de la cubierta del bacteriófago M13 al péptido o anticuerpo. La selección in vitro permite realizar rondas de filtración de bacteriófagos para seleccionar aquellos que poseen una alta afinidad por la molécula blanco (antígeno). La selección se produce mediante el “biopanning”; una unión in vitro antígeno-anticuerpo empleando el método de ELISA, “phage display”[1-3].

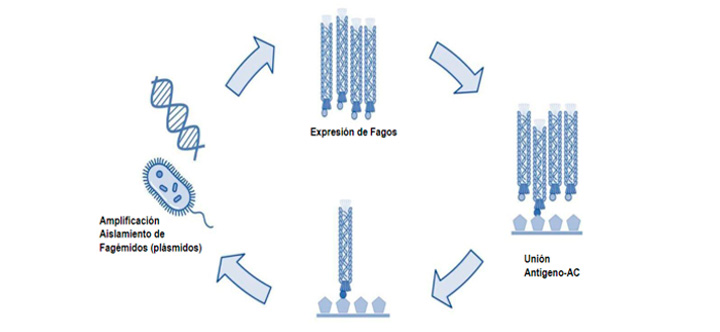

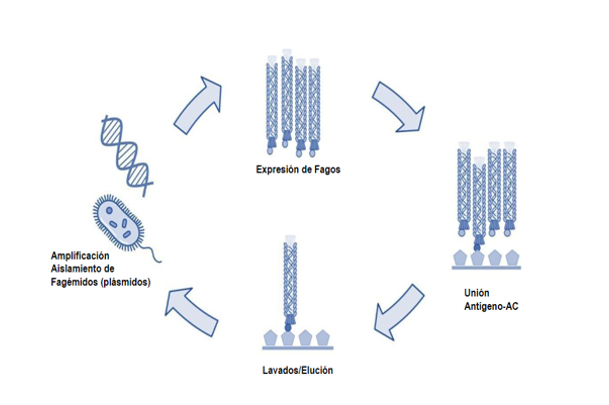

La eficiente selección depende de la alta afinidad del péptido (antígeno) adherido a la placa de ELISA y el anticuerpo fusionado a PIII y parte de la estructura de la cubierta del fago M13. En la Figura 1 se muestra el procedimiento “biopanning” de cuatro etapas. Inicialmente, la creación del fagémido por tanto la biblioteca que permite expresar las variantes de anticuerpos en el virus M13. La segunda etapa el procedimiento de selección mediante un ELISA, en donde una péptido o antígeno se inmoviliza en la placa a la cual se exponen los bacteriófagos purificados.

El siguiente proceso de lavados permite descartar a aquellos que poseen una baja o nula afinidad mediante una elución. Los bacteriófagos eludidos son amplificados en Escherichia coli, para recuperar el material genético mediante una extracción de plásmidos. Los plásmidos (famégidos) aislados se emplean para realizar una siguiente ronda en el proceso o “biopanning”. Este procedimiento se realizar 2 – 4 veces para lograr encontrar anticuerpos con una alta afinidad [2,3].

Figura 1. Etapas de selección de bacteriófagos por “Biopanning” [1,2].

Los procedimientos anteriores son laboriosos y no se produce un monitoreo cuantitativo de la afinidad antígeno-anticuerpo en el proceso. Idealmente, el proceso de selección de nuevos anticuerpos se beneficiaria de un monitoreo en cada ronda de “panning”; de modo que permita reducir costos y concentrar esfuerzos en las moléculas con alta afinidad y más prometedoras [1].

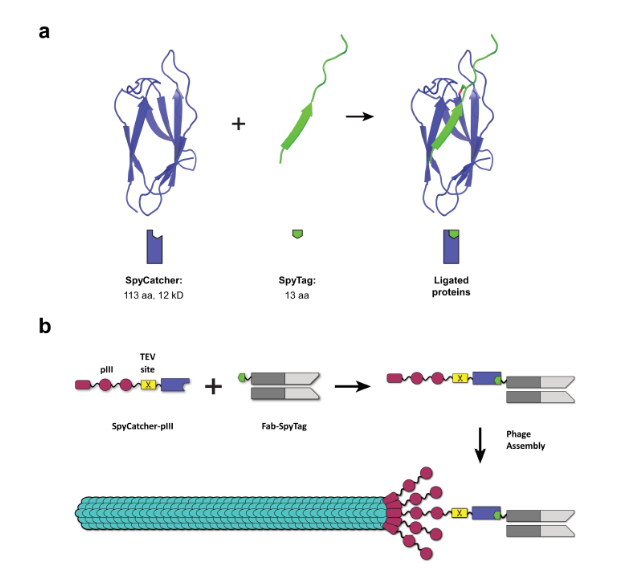

Se propone emplear la tecnología de “pegamento molecular” para acoplarla al sistema de despliegue de bacteriófagos. Los péptidos que realizan bionconjugación en la naturaleza tienen la capacidad de unir covalentemente dos proteínas. Un ejemplo son los péptidos SpyTag y SpyCatcher los cuales reaccionan espontáneamente mediante sus residuos de aspártico y lisina, respectivamente [2, 3]. Aprovechando al pegamento molecular se puede fusionar proteínas como anticuerpos con la estructura del bacteriófago M13. La propuesta conocida como “spy-display” que se describe en la Figura 2 [3], permite fusionar posterior a la expresión de la biblioteca a la proteína PIII con el anticuerpo mediada por SpyTag/SpyCatcher.

Lo anterior ofrece las siguientes ventajas: A) Se evitan los inconvenientes de ensamblaje de fago M13 por tamaños excesivo de proteínas fusionadas a PIII. B) El plásmido fagemido solo contiene las proteínas del M13, mejorando la producción viral. Mientas que un segundo plásmido de expresión se emplea para la expresión de los anticuerpos. C) Se pueden analizar anticuerpos de tamaño mayor a los de cadena sencilla. D) El sistema es modular y se podría añadir un fluoróforo, proteína biomarcador o enzima para monitorear la señal de la unión de los anticuerpos para decidir específicamente que población emplear para realizar la amplificación [3].

Figura 2. Sistema Spy-Display para desarrollo de anticuerpos. A) Componentes de la fusión covalente por bioconjugación (SpyTag / SpyCatcher). B) Fusión del anticuerpo (biblioteca) a la estructura del bacteriófago M13. El sitio de corte proteolítico TEV permite remover el anticuerpo seleccionado por despliegue de fagos.

Frecuentemente, durante la selección in vitro de biomoléculas se obtiene falsos positivos. Lo anterior eleva los costos y reduce la eficiencia de los métodos. En el caso del despliegue de anticuerpos, las bibliotecas poseen muchas veces versiones truncadas que se produce durante la maduración del fago M13 en la membrana. El sistema planteado Spy-display permite una producción y maduración intacta del virus M13 produciendo una versión “wild type” la cual es fusionada post-traduccionalmente a la biblioteca de anticuerpos. Se obtiene un población viral más robusta y niveles de infección mayores. Por lo tanto, el sistema muestra una prometedora manera de identificar nuevos anticuerpos y diseñar variantes de anticuerpos o sintéticos que pueden representar una contribución para pruebas de terapias mas eficaces o ensayos de detección rápida de virus en ensayos de bajo costo [2-4].

Referencias

1.- Passaretti, P., Khan, I., Dafforn, T.R. et al. Improvements in the production of purified M13 bacteriophage bio-nanoparticle. Sci Rep 10, 18538 (2020). https://doi.org/10.1038/s41598-020-75205-3

2.- Fierle, J.K., Abram-Saliba, J., Brioschi, M. et al. Integrating SpyCatcher/SpyTag covalent fusion technology into phage display workflows for rapid antibody discovery. Sci Rep 9, 12815 (2019). https://doi.org/10.1038/s41598-019-49233-7

3.- Kellmann SJ, Hentrich C, Putyrski M, Hanuschka H, Cavada M, Knappik A, Ylera F. SpyDisplay: A versatile phage display selection system using SpyTag/SpyCatcher technology. MAbs. 2023 Jan-Dec;15(1):2177978. doi: 10.1080/19420862.2023.2177978

4.- Qi H, Lu H, Qiu HJ, Petrenko V, Liu A. Phagemid vectors for phage display: properties, characteristics and construction. J Mol Biol. 2012;417(3):129–43. doi: 10.1016/j.jmb.2012.01.038.

El grafeno es un material versátil que permite fabricar desde dispositivos con pantallas flexibles y transparentes hasta potentes paneles solares, además tiene aplicaciones en diferentes industrias como aeronáutica, medicina y otros sectores que se investigan en la actualidad. Es por ello que es considerado un nanomaterial muy eficaz.

El discurso del físico Richard Feynman de 1959 “There’s Plenty of Room at the Bottom” es considerado como punto de partida en la investigación de la nanotecnología, pues se explica la probabilidad de que los átomos puedan ser manipulados directamente [1]. Feynman evoca un posible campo de investigación que entonces era inexplorado: lo extremadamente pequeño, el mundo de la nanoescalas.

A lo largo del tiempo se han desarrollado y alcanzado grandes avances entorno a la ingeniería química y nanotecnología como en 1985 se realizó el descubrimiento de los “Fullerenos” una nueva forma de carbono que revolucionaría la nanotecnología, a cargo de Los químicos Robert Curl, Sir Harold Kroto y Richard Smalley [2]. Otro avance significativo en 1991 fue la “Síntesis de Nanotubos de Carbono”, una de las estructuras más fundamentales de la nanotecnología, los cuales fueron sintetizados por los químicos Sumio Iijima y Thomas Ebbesen [3].

La creación de uno de los materiales más extraordinarios se dio en 2004 por los físicos Andre Geim y Konstantin Novoselov, que aíslan y caracterizan por primera vez el “grafeno” [4], una lámina de carbono de un solo átomo de espesor con propiedades extraordinarias. Las posibilidades y utilidades del grafeno se extienden hacia varias ramas como:

Electrónica Avanzada: El grafeno es un conductor eléctrico excepcional debido a su estructura de red de carbono de un solo átomo de espesor. Puede revolucionar la electrónica al permitir dispositivos mucho más pequeños y eficientes.

Materiales Compuestos: El grafeno puede ser integrado en polímeros, metales y otros materiales para mejorar sus propiedades mecánicas, conductivas y térmicas.

Aplicaciones Médicas: Puede utilizarse en sistemas de administración de fármacos, en biosensores y en imágenes médicas.

Filtros y Membranas: Debido a su estructura de red de átomos de carbono, el grafeno puede filtrar partículas extremadamente pequeñas, lo que lo hace útil en aplicaciones de purificación de agua y aire.

Aunque el grafeno tiene un potencial increíble gracias a su propiedades físicas y químicas, existen desafíos en su producción a gran escala y en la integración efectiva en aplicaciones comerciales. Por lo que dichas áreas son campos de investigación activa y la Ingeniería Química está abriendo nuevas fronteras en la creación de materiales a nivel nano, y los resultados son extraordinarios. Desde aplicaciones médicas revolucionarias hasta avances en la electrónica y la construcción, estos materiales están cambiando la forma en que vivimos y trabajamos.

Referencias bibliográficas

[1] R. Feyman, “There's Plenty of Room at the Bottom”, Caltech Eng And Sci. Feb, pp. 22-26, 1960. [Online]. https://calteches.library.caltech.edu/47/3/ES.23.5.1960.0.pdf. [Accessed: 19 -sep-2023]

[2] O. Vasilievna and U. Ortiz, “La estructura del fullereno C60 y sus aplicaciones”, Ciencia UANL, Vol. 5, no. 4, pp. 475-479, 2002. [Online]. https://www.redalyc.org/pdf/402/40250407.pdf. [Accedido: 18 -sep-2023]

[3] M. Maubert, S. Soto, C. León and M. Flores, “Nanotubos de carbono - la era de la nanotecnología”, Razón y Palabra, no. 68, 2009. [Online]. https://www.redalyc.org/pdf/1995/199520297017.pdf. [Accedido: 19 -sep-2023]

[4] A. Geim and K. Novoselov, “The rise of graphene”, Naturaleza Mater Vol. 6, no. 3, pp. 183-191, 2007. https://doi.org/10.1038/nmat1849. [Accessed: 17 -sep-2023]